公司动态

外国竞争对手的计算机性能快了5倍。 Tsinghua团队

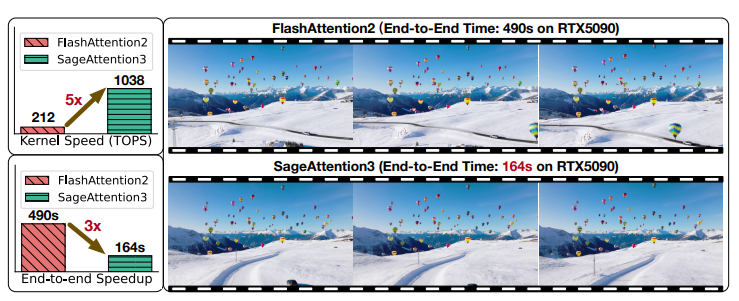

资料来源:DeepTech最近,Tsinghua大学的团队创建了第一个微型FP4护理机制,用于推理加速度,在NVIDIA RTX5090中获得了1038个计算机性能的高位。以前,NVIDIA RTX5090具有最快的计算机性能,并且与Stanford University在美国的闪光3相比,Sagaattente3的计算机性能快了五倍。实验表明,sgasattection3可以加速几个模型,而不会导致末端 - 端质量指标下降。同时,研究人员创建了前8位护理机制,可加速培训,创建了一个SageBWD,并研究了培训任务的可行性。我们发现,8位护理机制可以在不损失的情况下实现损失,但可以通过精细的调整任务损失,但是在当前阶段,D任务和预训练仍然存在一定的限制。 (来源:ARXIV),因为注意机制的复杂性是n²,护理机制的效率极为重要。为此,他们通过两个重要的贡献提高了注意力的效率。首先,研究人员使用新的NVIDIA Blackwell GPU Blackwell张紧器核来加速警告计算。实验表明,sagaattenion3可以加速插件形式的几种模型的推断。其次,研究团队是第一个采用低位注意机制进行培训任务的团队,现有的低位护理机制(包括FlashAttion3和Sgasattenion)仅专注于推理。在研究团队的最佳研究中,这项研究实现了在培训大型模型的培训中,在Vialbillow Bits Care中推断和开拓者的加速FP4注意机制的设计。当前,相关代码为开源https://github.com/thu-ml/sageattenion。解决两个主要障碍和一个困难之一的研究团队表明,护理机制FP4是面临障碍的两个主要问题,8位培训机制面临重要困难。具体而言,第一个问题是FP4量化的数值表示数量非常有限(只有15个理想的值),因此,无论是通过张紧器还是通过令牌量化方法,模型的精度都无法有效地维持。第二个问题是注意G图主要由范围内的小值组成[0.1]。 (注意:注意:图P是自动接头的中央输出矩阵,它表示入口序列中所有位置之间的相关权重)。当它以FP4格式直接量化时,这些值高度压缩了扩展系数的动态范围。但是,在硬件中,应对FP8数据类型采用量化系数,当以FP8格式表达比例系数时,此限制会导致明显的精度损失。第三个问题是研究人员在培训期间使用了8位护理机制,发现护理地图梯度特别容易受到进入梯度中积累的量化错误和错误的影响。为了解决第一个问题,研究人员在护理机制中提出了两个基质增殖。通过将量化组的大小限制为1x16(而不是基于张紧器或通道),该方法可以有效地抑制每个块中AT值的影响,同时提高FP4量化的准确性。为了解决第二个问题,研究团队提出了针对P MAP的两级量化方法,该方法充分利用了FP8量表系数的表示范围,并提高了P.护理图的量化准确性。特别地,此方法首先使用[0,448×6]到[0,448×6]的每个令牌的数值范围。为了解决第三个问题,研究人员确定了那些对PRE更敏感的人在挫折的传播中涉及的五个矩阵乘法操作的cision,并在FP16级别保持了该精度。 FP4注意加速推理,硬件和优化实现。在确定数据类型时,FP4数据类型有两个选项。第一个选项是NVFP4,其数据类型是E2M1,Tamquantified Block为1x16,扩展系数是E4M3数据的类型。第二个MXFP4选项。这也是E2M1数据的类型,但其量化的块大小为1×32,其扩展系数是E8M0数据的类型。经过一些比较,研究人员选择了NVFP4。这是因为NVFP4在注意时比MXFP4具有更高的精度。下表显示了在AI Cogvidax视频生成模型的所有层中使用MXFP4和NVFP4的准确性。结果表明,NVFP4的精度比MXFP4更好。 (来源:ARXIV)与FP16不同,在FP4 MATR的增殖中IX,FP32蓄能器的内存设计与操作注册设计A不同。研究人员的方法是调整蓄积累加器的设计,以保证芯片列以保证矩阵乘法的校正,研究设备可以相应地重组K级k并将其与量化核心进行处理。执行微型化量化时,您必须找到每列连续16个元素的最大值。但是,这16个元素是通过四个线程分布的,因此它首先需要线程中的最大值,然后螺纹之间的甲板将通过。 o合并操作,核的起作用明显较慢。研究人员优化了这种方法。这意味着可以将量化过程与在线软马克斯合并,这也可以计算E每行的最大值。 (来源:Arxiv)在特定的传统核中,消耗线包通常同时执行矩阵的乘法和存储操作,Myou是生产者子Process软件包仅负责加载输入数据。通过乒乓编程,消耗线程包之间的阶段重叠。但是,由于研究团队的FP4警告内核的注册资源有限,因此无法实施此方法。因此,研究团队设计了一个新的解决方案:生产商线程包之间的乒乓编程。生产者线程以下是为Trix乘法操作加载输入数据的以下内容,另一个包装子处理的软件包同时将输出的结果存储在全局内存中,而消耗子过程的包仅负责传输矩阵Multi-S内存结果的结果。在采用这种新设计时,可以在记录限制的数量下实现叠加矩阵和覆盖内存存储操作的n,从而提高了性能。 INT8注意用于训练,并进行相关的实验。据了解,与较低的量化护理有关的任务(例如flashats3和sgasattenion)仅适用于推理方案。如上所述,研究团队向SageBD提出了一种用于培训的INT8护理机制。该机制用INT8的精度量化了注意计算中七个矩阵乘法中的六个,导致精细调整任务中的性能损失为零。在实验中,研究人员在多种代表性模型(例如语言,图像和视频的生成)中证实了Prierattention3和SageBWD的有效性。具体而言,QWEN2.5和CARN3.2在文本任务测试实验中使用。 Cogvideox,Hunyuanvideo和Mochi用于EL视频文本任务测试实验。流和St在图像中的文本任务的测试实验中使用了能力扩散3.5。研究人员将此方法与Flashantent2,Xformers,sgasattection和Skeattention进行了比较22。应该注意的是,flashattents3只能在NVIDIA HOPPER GPU中执行。因此,FlashTent 2已经是可以在NVIDIA RTX5090和NVIDIA RTX4090中执行的最快版本。下图显示了RTX 5090核的工作速度的SGASATTENT3及其参考模型。与Xpuedes培训师相比,SapeAttention3与闪烁的2和8-11倍的加速度相比,加速度的加速度为4-5倍。 (来源:ARXIV)以下图显示了SageBD及其参考模型传播到NVIDIA RTX 4090。结果表明,SageBWD比Tinning 2中的闪光灯快1.67倍,在2和基于Triton的Xformer中,sagebwd的速度比Flash 2中的闪光灯快。 (来源:arxiv)在下表中,reseaRCHERS使用skeattention 3和其他警告方法比较了不同模型的末端 - 末端质量指标。结果表明,SGASATTECTION3在这些模型中从末端到极端几乎没有损失。 (来源:ARXIV)为了评估Sabebd在培训任务中的有效性,研究团队进行了两个实验。首先,研究人员调整了GSM8K,DROP,MMLU和HELLASWAG数据集的QWEN2.5(3B)和CALL3.2(1B)基本模型。下图显示了精细调整的损失的结果,表明SageBWD与BF16完美结合。 (来源:ARXIV)此外,在多个测试数据集中对响应质量研究团队的评估表明,SageBWD达到了与BF16相同的呈现。 (来源:ARXIV)第二,研究团队使用火焰模型(400m)在FineWedu执行了预训练任务。下图显示了损耗曲线。这表明SageBWD可以实现损失的收敛性,但是收敛速度相对较慢。这限制了预训练任务的适用性。 (来源:ARXIV)以下图显示了视频生成的比较示例,包括使用Sgasattennt3来生成Hum-Yuan的视频并生成具有稳定扩散3.5的图像。结果表明,Sagaattection3保持完整的生产质量。 (来源:ARXIV)以下图总结了末端到末端推理和训练延迟的改进。结果是与n和cogvideox进行了比较,我们表明sagaattection3在NVIDIA RTX5090.中达到了约3倍和2.4倍的推理,此外,SageBWD在使用8K/16K/16K Token Microbatch训练时达到了约1.15倍的加速度,NVIDIA nvidia invidia in nvidia in nvidia in nvidia rtx rtx。 (来源:ARXIV)然而,尽管SageBWD的性能比FP16更快,但研究人员观察到当前速度和理论上限之间存在较大差距。这个差距可能是由洛杉矶引起的Triton Nucleus实施的CK,研究团队计划更加优化它。在本文档中,研究人员宣布,在培训前调查低点护理在任务中的应用也是一个有希望的研究地址,值得探索。参考材料:相关文档:https://.org/pdf/2505.11594PEN代码来源:https://github.com/thu-ml/sageattention网站类型:刘Yakun

资料来源:DeepTech最近,Tsinghua大学的团队创建了第一个微型FP4护理机制,用于推理加速度,在NVIDIA RTX5090中获得了1038个计算机性能的高位。以前,NVIDIA RTX5090具有最快的计算机性能,并且与Stanford University在美国的闪光3相比,Sagaattente3的计算机性能快了五倍。实验表明,sgasattection3可以加速几个模型,而不会导致末端 - 端质量指标下降。同时,研究人员创建了前8位护理机制,可加速培训,创建了一个SageBWD,并研究了培训任务的可行性。我们发现,8位护理机制可以在不损失的情况下实现损失,但可以通过精细的调整任务损失,但是在当前阶段,D任务和预训练仍然存在一定的限制。 (来源:ARXIV),因为注意机制的复杂性是n²,护理机制的效率极为重要。为此,他们通过两个重要的贡献提高了注意力的效率。首先,研究人员使用新的NVIDIA Blackwell GPU Blackwell张紧器核来加速警告计算。实验表明,sagaattenion3可以加速插件形式的几种模型的推断。其次,研究团队是第一个采用低位注意机制进行培训任务的团队,现有的低位护理机制(包括FlashAttion3和Sgasattenion)仅专注于推理。在研究团队的最佳研究中,这项研究实现了在培训大型模型的培训中,在Vialbillow Bits Care中推断和开拓者的加速FP4注意机制的设计。当前,相关代码为开源https://github.com/thu-ml/sageattenion。解决两个主要障碍和一个困难之一的研究团队表明,护理机制FP4是面临障碍的两个主要问题,8位培训机制面临重要困难。具体而言,第一个问题是FP4量化的数值表示数量非常有限(只有15个理想的值),因此,无论是通过张紧器还是通过令牌量化方法,模型的精度都无法有效地维持。第二个问题是注意G图主要由范围内的小值组成[0.1]。 (注意:注意:图P是自动接头的中央输出矩阵,它表示入口序列中所有位置之间的相关权重)。当它以FP4格式直接量化时,这些值高度压缩了扩展系数的动态范围。但是,在硬件中,应对FP8数据类型采用量化系数,当以FP8格式表达比例系数时,此限制会导致明显的精度损失。第三个问题是研究人员在培训期间使用了8位护理机制,发现护理地图梯度特别容易受到进入梯度中积累的量化错误和错误的影响。为了解决第一个问题,研究人员在护理机制中提出了两个基质增殖。通过将量化组的大小限制为1x16(而不是基于张紧器或通道),该方法可以有效地抑制每个块中AT值的影响,同时提高FP4量化的准确性。为了解决第二个问题,研究团队提出了针对P MAP的两级量化方法,该方法充分利用了FP8量表系数的表示范围,并提高了P.护理图的量化准确性。特别地,此方法首先使用[0,448×6]到[0,448×6]的每个令牌的数值范围。为了解决第三个问题,研究人员确定了那些对PRE更敏感的人在挫折的传播中涉及的五个矩阵乘法操作的cision,并在FP16级别保持了该精度。 FP4注意加速推理,硬件和优化实现。在确定数据类型时,FP4数据类型有两个选项。第一个选项是NVFP4,其数据类型是E2M1,Tamquantified Block为1x16,扩展系数是E4M3数据的类型。第二个MXFP4选项。这也是E2M1数据的类型,但其量化的块大小为1×32,其扩展系数是E8M0数据的类型。经过一些比较,研究人员选择了NVFP4。这是因为NVFP4在注意时比MXFP4具有更高的精度。下表显示了在AI Cogvidax视频生成模型的所有层中使用MXFP4和NVFP4的准确性。结果表明,NVFP4的精度比MXFP4更好。 (来源:ARXIV)与FP16不同,在FP4 MATR的增殖中IX,FP32蓄能器的内存设计与操作注册设计A不同。研究人员的方法是调整蓄积累加器的设计,以保证芯片列以保证矩阵乘法的校正,研究设备可以相应地重组K级k并将其与量化核心进行处理。执行微型化量化时,您必须找到每列连续16个元素的最大值。但是,这16个元素是通过四个线程分布的,因此它首先需要线程中的最大值,然后螺纹之间的甲板将通过。 o合并操作,核的起作用明显较慢。研究人员优化了这种方法。这意味着可以将量化过程与在线软马克斯合并,这也可以计算E每行的最大值。 (来源:Arxiv)在特定的传统核中,消耗线包通常同时执行矩阵的乘法和存储操作,Myou是生产者子Process软件包仅负责加载输入数据。通过乒乓编程,消耗线程包之间的阶段重叠。但是,由于研究团队的FP4警告内核的注册资源有限,因此无法实施此方法。因此,研究团队设计了一个新的解决方案:生产商线程包之间的乒乓编程。生产者线程以下是为Trix乘法操作加载输入数据的以下内容,另一个包装子处理的软件包同时将输出的结果存储在全局内存中,而消耗子过程的包仅负责传输矩阵Multi-S内存结果的结果。在采用这种新设计时,可以在记录限制的数量下实现叠加矩阵和覆盖内存存储操作的n,从而提高了性能。 INT8注意用于训练,并进行相关的实验。据了解,与较低的量化护理有关的任务(例如flashats3和sgasattenion)仅适用于推理方案。如上所述,研究团队向SageBD提出了一种用于培训的INT8护理机制。该机制用INT8的精度量化了注意计算中七个矩阵乘法中的六个,导致精细调整任务中的性能损失为零。在实验中,研究人员在多种代表性模型(例如语言,图像和视频的生成)中证实了Prierattention3和SageBWD的有效性。具体而言,QWEN2.5和CARN3.2在文本任务测试实验中使用。 Cogvideox,Hunyuanvideo和Mochi用于EL视频文本任务测试实验。流和St在图像中的文本任务的测试实验中使用了能力扩散3.5。研究人员将此方法与Flashantent2,Xformers,sgasattection和Skeattention进行了比较22。应该注意的是,flashattents3只能在NVIDIA HOPPER GPU中执行。因此,FlashTent 2已经是可以在NVIDIA RTX5090和NVIDIA RTX4090中执行的最快版本。下图显示了RTX 5090核的工作速度的SGASATTENT3及其参考模型。与Xpuedes培训师相比,SapeAttention3与闪烁的2和8-11倍的加速度相比,加速度的加速度为4-5倍。 (来源:ARXIV)以下图显示了SageBD及其参考模型传播到NVIDIA RTX 4090。结果表明,SageBWD比Tinning 2中的闪光灯快1.67倍,在2和基于Triton的Xformer中,sagebwd的速度比Flash 2中的闪光灯快。 (来源:arxiv)在下表中,reseaRCHERS使用skeattention 3和其他警告方法比较了不同模型的末端 - 末端质量指标。结果表明,SGASATTECTION3在这些模型中从末端到极端几乎没有损失。 (来源:ARXIV)为了评估Sabebd在培训任务中的有效性,研究团队进行了两个实验。首先,研究人员调整了GSM8K,DROP,MMLU和HELLASWAG数据集的QWEN2.5(3B)和CALL3.2(1B)基本模型。下图显示了精细调整的损失的结果,表明SageBWD与BF16完美结合。 (来源:ARXIV)此外,在多个测试数据集中对响应质量研究团队的评估表明,SageBWD达到了与BF16相同的呈现。 (来源:ARXIV)第二,研究团队使用火焰模型(400m)在FineWedu执行了预训练任务。下图显示了损耗曲线。这表明SageBWD可以实现损失的收敛性,但是收敛速度相对较慢。这限制了预训练任务的适用性。 (来源:ARXIV)以下图显示了视频生成的比较示例,包括使用Sgasattennt3来生成Hum-Yuan的视频并生成具有稳定扩散3.5的图像。结果表明,Sagaattection3保持完整的生产质量。 (来源:ARXIV)以下图总结了末端到末端推理和训练延迟的改进。结果是与n和cogvideox进行了比较,我们表明sagaattection3在NVIDIA RTX5090.中达到了约3倍和2.4倍的推理,此外,SageBWD在使用8K/16K/16K Token Microbatch训练时达到了约1.15倍的加速度,NVIDIA nvidia invidia in nvidia in nvidia in nvidia rtx rtx。 (来源:ARXIV)然而,尽管SageBWD的性能比FP16更快,但研究人员观察到当前速度和理论上限之间存在较大差距。这个差距可能是由洛杉矶引起的Triton Nucleus实施的CK,研究团队计划更加优化它。在本文档中,研究人员宣布,在培训前调查低点护理在任务中的应用也是一个有希望的研究地址,值得探索。参考材料:相关文档:https://.org/pdf/2505.11594PEN代码来源:https://github.com/thu-ml/sageattention网站类型:刘Yakun 上一篇:特斯拉4月份在欧盟的销售不足,与上一年相比, 下一篇:没有了